我們需要什麼樣的人工智能倫理與治理

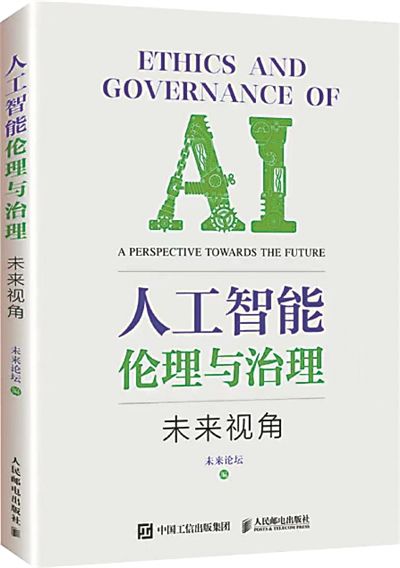

作者: 未來論壇

出版社: 人民郵電出版社

出版時間: 2023年2月

【字裡行間】

◎孫 瑜

開年以來,人工智能領域現象級應用ChatGPT引發全球關注和討論。美國人工智能公司OpenAI最新發布的GPT-4則更為強大,不僅可以通過律師考試,還可以將一張手繪草圖變成一個可運行網站,或在60秒內建立一個視頻游戲……在ChatGPT生成的一行行智能回答的背后,對人工智能的信任、責任、倫理、法律等思考也逐步從幕后走向前台,成為熱門話題。

怎樣理解人工智能創造的藝術?人工智能時代我們該如何定義“公平”?如何把人類知識和AI算法結合以防止風險?這些話題的背后,最根本的問題是:我們需要什麼樣的AI倫理和AI治理?

不可否認,ChatGPT還有很多局限性,但人類應為應對AI可能帶來的風險做好准備。在AI技術如火如荼發展的同時,關於AI倫理和AI治理,社會亟須形成廣泛明確的共識。

今年2月,《人工智能倫理與治理·未來視角》出版。30多位來自學術界或科技企業的專家學者,圍繞“AI向善的理論與實踐”“AI的公平性”“AI與風險治理”“AI決策的可靠性和可解釋性”“用戶數據隱私”“包容性的AI”六大專題分享了建設性的意見。

其中不少觀點為理解人工智能熱潮提供了思路。

例如,人工智能是否會威脅人類?以ChatGPT為代表的大模型技術發展之快,很容易令人產生幻覺——似乎科幻電影裡的想象已然近在咫尺,似乎將ChatGPT和智能機器人結合起來,我們就可以把《銀翼殺手2049》裡的虛擬女孩喬伊搬進現實。

微軟全球資深副總裁洪小文認為,現在的人工智能是“強人工智能很弱,弱人工智能很強”,對於通用人工智能的威脅,其實沒必要太過擔憂。今天的人工智能根本不具備系統化解問題的功能,通用人工智能的實現還“沒有影子”。

對於這個問題,復旦大學浩清特聘教授、博士生導師漆遠介紹了頂尖科學家們的觀點。他提到,麻省理工學院頂尖科學家之間曾舉行辯論,主題為“將來機器人是否能夠像牛頓和愛因斯坦等科學家一樣發現科學定律”。現場的研究者一派認為不可能,這個技術的“種子”不存在﹔另一派則認為,有可能實現,但技術路線不得而知。

盡管人類和超級人工智能之間還有不短的距離,但思考其潛在風險,其即將或已引發的倫理與治理問題,仍非常必要。漆遠認為,面對人工智能可能存在的風險,系統設計要留有“冗余”,需要將人和智能機器看作一個大系統,從整體來思考和構建可信和可靠性。

再如,數據隱私保護問題。很多企業掌握著大量數據,但數據歸屬權卻並不清晰。例如,醫院拍攝的醫學影像屬於患者還是醫院?

美團副總裁、首席科學家夏華夏給出了3點具體看法。具體到科技企業,如果收集數據,應該告訴用戶數據未來的用途﹔保護數據隱私,企業要有自律精神,需要有一套數據使用制度以及委員會監管﹔數據安全需要技術保障,但起兜底作用的還是法律法規,數據保護相關法律法規對企業是約束,也可以讓用戶放心。

清華大學蘇世民書院院長薛瀾認為,人工智能領域比較好的治理模式是“敏捷治理”,要求政府與企業互相溝通,共同討論潛在風險並判斷如何有意識地加以規避,建立合理的治理框架。

在書籍第二章內容裡,專家分享了全球AI治理進展和新動態,梳理了德國、日本、新加坡等國家及歐盟、經濟合作與發展組織等關於AI治理的政策。同時,書中還制作了國內外重要數據監管法律法規的時間軸,清晰顯示了數據監管越來越嚴厲的趨勢。這些內容可令讀者較迅速地了解人工智能領域治理概況和相關原則。

目前,人工智能仍以極快的速度發展著。人類在道德和實踐理性層面上的進步,也要跟上技術發展的節奏。正如未來論壇青年理事、中國人民大學法學院副教授郭銳在該書導論中所言,意識到並理解隨新技術產生的社會倫理和治理問題,著手應對,“人類就是在實踐最高意義上的自由”。希望社會各界能認識AI,擁抱它、適應它、影響它並引領它,共同建立起一個能讓人類從人工智能中受益並防止其產生危害的治理體系。

關注公眾號:人民網財經

關注公眾號:人民網財經

分享讓更多人看到

- 評論

- 關注

微信掃一掃

微信掃一掃

第一時間為您推送權威資訊

第一時間為您推送權威資訊

報道全球 傳播中國

報道全球 傳播中國

關注人民網,傳播正能量

關注人民網,傳播正能量